A/B Testing, Channel Testing, Lifecycle Testing, Holdout Testing trong Ecommerce và CRO

Một vài viết 8000 từ về những nguyên tắc rất quan trọng khi làm A/B Test. ;)

Bạn hiểu như thế nào là A/B Testing, A/B Split Testing, Channel Testing, Lifecycle Testing, Holdout Testing? Vì sao với Ecommerce và CRO, bạn cần phải thực hiện tất cả các test này?

Cảm thấy ong đầu chưa? Ong rồi thì tốt đó 😂.

Mình khuyến khích bạn nắm chắc các kỹ thuật test này, nếu bạn thực sự muốn “level up” kỹ năng Ecommerce Marketing và vươn ra thị trường Ecom quốc tế. Chúng là câu chuyện “cơm bữa” hàng ngày của một Ecom Marketer (cũng là của mình).

Từ trải nghiệm làm Digital của cá nhân mình, A/B Testing là một trong những thứ mà mình thấy bị lạm dụng nhất.

Có người cái gì cũng A/B Test, từ nhỏ tới to… và lắm khi test mà chẳng hiểu vì sao lại test. Test xong cũng chẳng biết làm gì với cái Outcome đã thu được nữa.

Có người lại cho rằng A/B Test chẳng mang lại lợi ích gì. Thành ra chẳng bao giờ test.

Có người lại cứ khăng khăng test những cái mà thực sự rất không có ý nghĩa, nếu không nói là phí thời gian.

Một số người khác rất tự tin là biết A/B Test nhưng chứng kiến cách họ làm test xong mà mình thấy… sai hơi nhiều. Có lẽ nên kiềm chế sự tự tin. Tém tém lại thì tốt hơn.

Trong mảng Ecommerce, khi nói đến A/B Test, thường người ta sẽ nghĩ ngay đến tối ưu tỷ lệ chuyển đổi CRO (Conversion Rate Optimization) cho Website. Nhưng bạn cần chú ý Website chỉ là một kênh trong rất nhiều kênh khác. Từ Website cho đến Organic Social cho đến quảng cáo trả phí, bạn đều có thể thực hiện các A/B test.

Là một người ăn-thở-và-sống với Ecommerce mỗi ngày, mình nhấn mạnh A/B Test cực kỳ quan trọng trong thương mại điện tử. Bản thân mỗi Ecom Marketer cần hiểu rõ hoạt động này cần được thực hiện ra sao và cần biết cách làm. Nếu bạn muốn dấn thân vào thị trường Ecom nước ngoài, trau dồi được kỹ năng A/B Testing sẽ là lợi thế của bạn.

Hôm nay mình sẽ chia sẻ với bạn những nền tảng cơ bản liên quan đến A/B Test. Mình hy vọng sẽ có ích cho bạn nhé.

Có gì trong bài viết này:

A/B Testing, Split Testing và A/B Split Testing

Statistical Significance (ý nghĩa thống kê)

8 lỗi sai quá cơ bản khi thực hiện A/B Testing

Cách thực hiện A/B Testing

Incrementality trong Ecommerce

Holdout Testing

Cách mình triển khai một Holdout Testing

Tài nguyên thêm để tự học về A/B Testing

Rồi, bây giờ hãy cùng mình đi vào từng mục.

Note: Vì lý do bảo mật, mình sẽ không chia sẻ kết quả thực tế của các A/B Testing mình đã thực hiện.A/B Split Testing là gì?

Có 3 khái niệm mà chúng ta cần làm rõ: A/B Testing, Split Testing và A/B Split Testing.

1. A/B Testing

A/B Testing là một phương pháp nghiên cứu được sử dụng để kiểm tra hai phiên bản khác nhau nhằm xác định phiên bản nào mang lại hiệu quả mục tiêu tốt nhất.

Với một A/B Test, hai phiên bản bao gồm:

A: Là bản gốc (Orginal / Control), không có gì thay đổi.

B: Là bản có sự thay đổi (Variation)

Như vậy, cái cốt lõi của A/B Testing là chỉ thay đổi một biến số, biến B. Còn lại tất cả các thành tố khác đều giống nhau, không thay đổi.

Mình lấy ví dụ như thế này, mình vừa làm xong 1 video sinh nhật cho đứa bạn thân. Mình có hai bài nhạc muốn dùng làm nhạc nền cho video. Mình và bạn thân đều rất thích bài hát A, nhưng mình nhớ là có lần bạn thân mình nói cũng thích bài hát B lắm. Mình phân vân không biết nên chọn bài nào.

Mình nghĩ tới việc làm hai video với hai bài nhạc sau đó gửi cho những người bạn khác trong nhóm đều chơi với người bạn thân để họ cho mình lời khuyên. Bài nào nhận được nhiều vote thì mình sẽ dùng bài hát đó cho video.

Giả sử mình có 30 người bạn có thể nghe và test nhạc cho mình. Mình sẽ gửi cả hai video cho 30 người bạn này, bảo họ nghe cả hai và sau đó vote cho mình video họ thích nhất.

Đây chính là ví dụ A/B Testing điển hình. Biến duy nhất thay đổi là bài hát, còn lại không có gì khác. Kể cả mẫu thử (30 người) cũng không thay đổi.

2. Split Testing

A/B Testing và Split Testing thường được sử dụng thay thế cho nhau. Tuy nhiên, chính xác thì về bản chất, hai loại test này không giống nhau.

Split Testing không giới hạn ở số biến, nghĩa là bạn có thể thay đổi 1 yếu tố hoặc nhiều yếu tố. Thêm nữa, mẫu thử sẽ được chia đều cho các nhóm, một nhóm sẽ thấy phiên bản gốc (Control), các nhóm còn lại sẽ thấy các biến thể (Variation).

Mình sẽ giải thích cụ thể ở phần dưới đây.

A/B Split Testing là sự kết hợp của A/B Testing và Split Testing

Tức là test hai phiên bản khác nhau với chỉ một biến thay đổi và trên mẫu thử cùng kích thước nhưng không đồng nhất hoàn toàn.

Cũng với ví dụ về làm video bài hát cho bạn mình trên kia. Khi thực hiện A/B Split Testing, mình sẽ làm như thế này:

Phân 30 người bạn thành 2 nhóm ngẫu nhiên, mỗi nhóm 15 người.

Mỗi nhóm gửi một bài hát. Nhóm 1 mình gửi bài hát A, Nhóm 2 mình gửi bài B.

Nhóm nào có số vote nhiều hơn cho một bài hát thì mình sẽ chọn bài hát đó cho video. Chẳng hạn nếu nhóm 1 có 8 người vote chọn bài A, trong khi nhóm 2 có 11 người vote chọn bài B, vậy mình sẽ dùng bài B.

Ở đây bạn có nhận thấy điều gì khác không, đó chính là mẫu thử không đồng nhất. Mặc dù mỗi nhóm đều có 15 người, nhưng mỗi nhóm nghe 1 bài, chứ không phải cùng được nghe cả hai bài. Thêm nữa, mỗi nhóm đều là các con người khác nhau. Dù bài B được vote nhiều hơn ở nhóm 2, nhưng nhớ là 15 người ở nhóm 1 chưa được nghe bài này, và ngược lại bài A có số vote 1 ít hơn ở nhóm 1, nhưng các thành viên ở nhóm B chưa được nghe. So với A/B Testing trên cùng một mẫu thử thì Split Testing này có độ tin cậy kém hơn và do vậy, phải được đánh giá với góc nhìn khác.

Hiển nhiên, ví dụ mình đưa ra khá đơn giản. Trong thực tế, Split Testing phức tạp hơn nhiều và nó phổ biến trong CRO và Ecommerce vì một lý do: Bạn không thể tách đều Traffic, Users, Visitors, Email Subscribers… ra để mà test được. Bạn không thể tạo ra hai Landing Page rồi đẩy toàn bộ Traffic vào hai trang cùng lúc.

Có bạn tranh luận, “nếu test Landing Page 1 trước rồi đẩy toàn bộ Traffic vào đó trong 10 ngày; sau 10 ngày thì lại test Landing Page 2 và đẩy toàn bộ Traffic vào đó cũng trong 10 ngày thì sao?”

Làm như thế thì có gọi là test nữa không? Khi mà yếu tố thời gian đã thay đổi, 10 ngày từ mùng 1 đến mùng 10 hoàn toàn khác với 10 ngày từ 11 đến 20. Trong mỗi 10 ngày đó, bao yếu tố kinh tế, nền tảng, hành vi… đã thay đổi? Đó là mình còn chưa nói đến Traffic đến trong 10 ngày trước đâu phải cũng giống với Traffic đến vào 10 ngày sau? Bạn đâu kiểm soát được Users/Visitors.

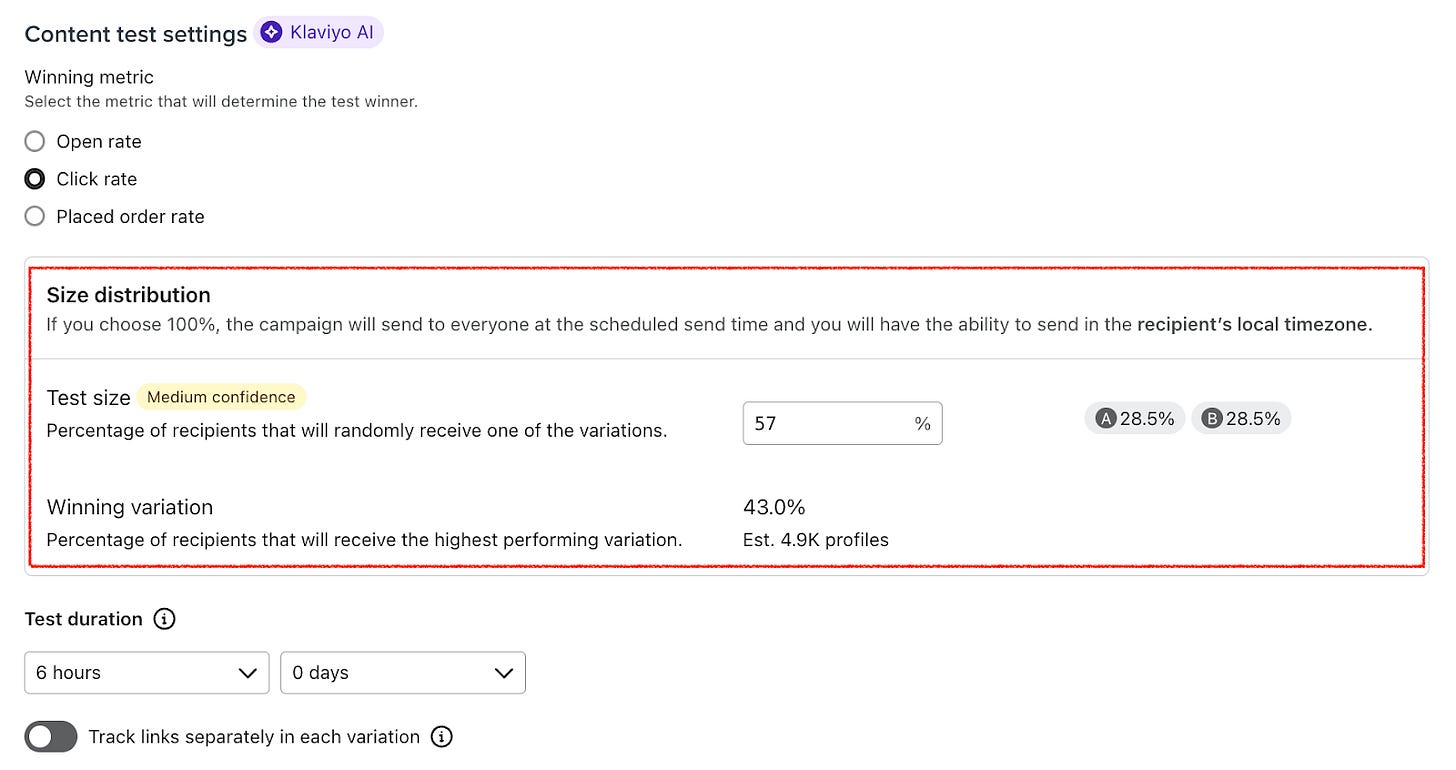

Một ví dụ khác, khi bạn test các Subject Line rồi Email Content, bạn cũng thực hiện A/B Split Test, chứ không phải A/B Test trên cùng một mẫu thử. Vì sao? Vì giả sử Database của bạn có 10.000 Customers coi, bạn không thể gửi Email 1 cho ngần này người, xong lại gửi tiếp Email 2 với cùng nội dung chỉ khác tiêu đề email cho họ nữa. Khách hàng sẽ cực kỳ khó chịu và có thể đánh dấu email của bạn là Spam. Đấy là lý do vì sao test trên các nền tảng Email Marketing thường là Split Testing. Bạn cứ nhìn ví dụ dưới đây từ Klaviyo sẽ thấy rõ. Klaviyo đề xuất bạn “split” số người gửi ra để test.

Bạn xem bảng so sánh A/B Testing truyền thống và A/B Split Testing dưới đây để hiểu rõ hơn:

Hiệu quả mục tiêu của A/B Split Testing có thể là tăng số lần nhấp chuột vào một Call to Action (CTA), tăng số Email Subscriber, tăng số lượt Add to Cart, Checkout, tăng số lượng mua hàng, tăng AOV (Average Order Value), hoặc bất kỳ mục tiêu nào khác mà Brand muốn đạt được.

A/B Split Testing giúp bạn kiểm chứng các giả thuyết và ý tưởng. Hay nói cách khác, nhờ việc thực hiện A/B Split Testing, bạn sẽ thu được các kết quả thực tế để quyết định đâu là giả thuyết và ý tưởng thực sự “work”, chứ không phải chỉ dựa trên cảm tính, phỏng đoán, “Best Practices”, “ai cũng làm thế”, hay “sếp bảo sao em làm vậy”.

Hiển nhiên, cảm tính, phỏng đoán, “Best Practice”, lời sếp nói, lời một chuyên gia nói… có lúc có ích và đúng, nhưng không phải lúc nào cũng thế — nếu không nói là lắm khi sai hoàn toàn.

Statistical Significance (ý nghĩa thống kê)

Bất cứ Marketer nào khi thực hiện A/B Split Testing cũng cần phải nắm được Statistical Significance (ý nghĩa thống kê). Đây là thước đo xác suất cho bạn biết sự khác biệt trong kết quả giữa phiên bản A và B không phải do ngẫu nhiên mà đáng tin cậy.

Trong ngữ cảnh của một Split Test, nếu một thử nghiệm đạt được ý nghĩa thống kê, điều đó có nghĩa là bạn có thể tự tin phiên bản Winner tốt hơn phiên bản còn lại, với mức độ chắc chắn cao.

Nếu kết quả A/B Test cho thấy một phiên bản A thắng với độ tin cậy thống kê 95%, có nghĩa là có 95% khả năng kết quả đó là đúng và bạn đã tìm được Winner rồi. Cái 5% còn lại nghĩa là khả năng nếu bạn lặp lại bài Test, bạn sẽ có kết quả khác hoặc kết quả không kết luận được.

Nếu bạn tung một đồng xu 10 lần liên tiếp, có 1/1024 khả năng nó sẽ rơi vào mặt ngửa tất cả các lần — chỉ do ngẫu nhiên. Khả năng này rất thấp. Nhưng giả sử có 5000 người cùng tung đồng xu thì khả năng cao là sẽ có ít nhất 1 người nhận được 10 lần mặt ngửa liên tiếp (xác suất xảy ra là 99,24%). Như bạn có thể thấy, khi bạn thực hiện một thứ gì đó đủ số lần (hoặc khi có càng nhiều người cùng thực hiện bài test) thì các sự kiện tưởng khó xảy ra khả năng cao sẽ chắc chắn xảy ra.

Đấy là lý do vì sao khi thực hiện A/B Split Testing, bạn cần đánh giá mẫu thử. Mẫu càng lớn (với các điều kiện khác không đổi, ngoại trừ biến được test) thì nó sẽ cho bạn kết quả càng chính xác hơn. Mẫu quá nhỏ thì sẽ dễ dẫn tới rủi ro là kết quả ngẫu nhiên, không đáng tin cậy.

Nếu bạn đang muốn làm một A/B Split Test mà mẫu quá nhỏ thì bạn cần phải cân nhắc kỹ hoặc chọn lọc kỹ hơn cái bạn đang muốn test.

Tính toán được ý nghĩa thông kê rất phức tạp cho nên gần như các tool làm A/B Test hoặc platform có tính năng này đều tự tính cho bạn. Bạn không cần phải tự tính tay. Industry standard cho ý nghĩa thống kê đó là 95%. Đây cũng là con số mà các Platform thường sử dụng để xác định Winner cho các A/B Test.A/B Split Testing là một phần đặc trưng của CRO. Chứ không phải A/B Testing là CRO.

Vì sao mình nhấn mạnh điều này? Bởi vì có một số người nhầm lẫn rằng triển khai CRO là cứ A/B Split Testing, nghĩa là test đủ thứ, test hết cái này đến cái khác.

Quá sai!

A/B Split Testing không phải là tìm kiếm các ý tưởng mới. Nó không phải cứ test là sẽ tìm ra cách để tối ưu Conversion. Bạn cần nhớ A/B Split Testing là một bước của một quá trình tối ưu CR (Conversion Rate) và nó là bước tiếp theo sau khi bạn đã thực hiện các bước quan trọng trước đó.

Cụ thể, trước khi nghĩ tới A/B Split Testing, bản thân bạn và Team phải phân tích và hiểu rõ được hành vi hiện tại của người dùng trên Website, vấn đề “drop off” (giảm tỷ lệ chuyển đổi) là ở đâu, Website có gặp trục trặc gì không, lượng Traffic vào Website biến động ra sao, có yếu tố gì đang tác động tới Conversion…

Trước khi nghĩ tới A/B Split Testing, bạn cũng phải phát triển được các giả thuyết chắc chắn, có cơ sở, “data-driven”, “insight-driven” và xác định được đúng các yếu tố cần test. Chứ không phải cứ nghĩ ra cái gì trong đầu là test hết.

Ví dụ, AppSumo đã A/B Test kích thước của CTA “Buy Now” và CR của họ tăng lên 7.31%. Rõ ràng nút lớn hơn sẽ giúp người dùng dễ tap hơn trên mobile đúng không? Nó cũng trông nổi bật hơn trên màn hình nữa.

LƯU Ý:

1. Trong giới Ecommerce, A/B Testing truyền thống và A/B Split Testing thường được gọi như nhau. Vì bản chất ai cũng hiểu phải tách mẫu. Cho nên để đơn giản và ngắn gọn, từ phần này trở đi mình sẽ gọi là A/B Testing nhé.

2. Ngoài test hai yếu tố thì còn có một loại test khác là Multivariant Testing (MVT), tức là test với nhiều biến thay đổi. Loại test này phức tạp hơn trong phân tích và đòi hỏi mẫu phải rất lớn để đảm bảo độ tin cậy. Thường bạn chỉ nên test hai phiên bản, tức là làm A/B Test thôi vì nếu test nhiều biến cùng lúc, bạn sẽ khó mà xác định được điều gì thực sự đóng vai trò quyết định trước kết quả nhận được.Những lỗi sai quá cơ bản khi làm A/B Testing

Trước khi đi vào cách để làm A/B Test, mình muốn đi sâu vào những lỗi sai hết sức phổ biến và quá cơ bản mà mình rất nhiều người đã/đang mắc phải (mình cũng đã từng mắc nhưng thật tốt là mình đã nhận ra). Cách sửa các lỗi sai này cũng là nguyên tắc cần phải nhớ trong A/B Test mà nếu như bạn không nắm chắc thì hỏng đó.